국내 대표적인 로봇산업 전문가인 이경준 한국AI·로봇산업협회 본부장이 글로벌 로봇 동향과 기술에 대한 심층적이고 다각적 이해를 제공하는 연재 ‘로봇콘서트’를 시작한다. 로봇이라는 기술적 진보를 넘어 인문사회학적 함의를 탐구하고자 한다. 로봇 기술을 마치 오케스트라 연주처럼 다양한 관점과 목소리로 풀어내는 연재로서 각 회차는 음악 용어에 비유되는 로봇 관련 주제를 심도 있게 접근한다.

여섯 번째는 ‘아주 빠르게’ 혹은 ‘생기 있게’를 뜻하는 비바체(Vivace)이다. 인류 기술은 물리 세계를 디지털 정보로 바꾸는 ‘대디지털화’를 거쳐, 이제 AI가 현실 세계에서 몸을 가지고 노동하는 ‘대육화’ 단계로 진입하고 있다. CES 2026은 LLM에서 VLA로 진화한 피지컬 AI가 로봇의 시각·언어 이해·행동 생성 능력을 통합하며 모라벡의 역설을 무너뜨리는 전환점이 됐다. 산업·가정·로봇 손 기술까지 확장된 피지컬 AI는 아직 한계가 있지만, 인간 노동과 삶의 구조를 근본적으로 바꿀 흐름으로 자리 잡고 있다.

분명한 것은 2026년의 라스베이거스에서

기계가 걷고 인간에게 필요한 일을 시작해

그 행진은 멈추지 않을 것이라는 사실이다.

인류 기술의 역사는 정보를 다루는 방식의 진화였다. 지난 반세기 동안 우리는 물리적 실체를 0과 1이라는 디지털 비트(Bit)로 변환하는 데 몰두해왔다. 책은 전자책이 되었고, 음악은 스트리밍 데이터가 되었으며, 화폐는 암호화된 장부가 됐다. 이 ‘대디지털화’(Great Digitization)의 정점에서 탄생한 것이 바로 ‘생성형 AI’(Generative AI)였다.

GPT와 같은 거대 언어 모델(LLM)은 인류의 지식을 학습하여 유창한 언어를 구사하고, 아름다운 이미지를 생성해냈다. 그러나 이 지능은 스크린 뒤에 갇힌 ‘뇌’에 불과했다. 그것은 시를 쓸 수는 있었지만, 펜을 들어 종이에 글자를 적을 수는 없었다.

올해 1월, 라스베이거스에서 열린 소비자 가전 전시회(이하 CES) 2026은 이 흐름이 근본적으로 역전됐음을 선언하는 역사적인 변곡점으로 보였다. 이제 인공지능은 스크린을 뚫고 나와 물리적 실체를 입기 시작했다. 필자는 이를 ‘대육화’(The Great Incarnation)라고 정의하고 싶다. AI가 단순한 연산 작용을 넘어, 물리 법칙이 지배하는 현실 세계로 내려와 몸을 입고(Incarnation), 중력과 마찰력, 관성과 상호작용하며 노동을 수행하는 현상이 곳곳에서 보이기 시작한 것이다.

음악 이론에서 ‘비바체’(Vivace)는 악보의 상단에 적혀 연주자에게 ‘빠르고 생기 있게’, 혹은 ‘활기차게’ 연주할 것을 주문하는 지시어다. 라틴어 ‘vivax’에 어원을 둔 이 단어는 단순히 속도의 빠름만을 의미하지 않는다. 그것은 생명력이 넘치고(vivacious), 역동적이며, 마치 살아 숨 쉬는 듯한 에너지를 음악에 불어넣으라는 철학적 요구이기도 하다.

2026년 1월, 라스베이거스의 겨울을 뜨겁게 달군 ‘CES 2026’의 현장은 그야말로 피지컬 AI가 몸을 가지고 연주하는 거대한 비바체였다. 챗봇과 생성형 이미지를 넘어, 이제 AI는 팔과 다리를 가지고 걷고, 뛰고, 물건을 집어 올리며, 심지어 인간과 복싱이나 탁구 대결을 펼치고 있었다.

라이다 통해 눈을 갖춘 로봇으로 진화

‘대육화’를 이해하기 위해서는 먼저 로봇을 구동하는 지능의 본질적인 변화를 이해해야 한다. 과거의 로봇은 정해진 좌표를 따라 움직이는 자동화 기계(Automaton)에 불과했다. 그러나 2026년의 로봇은 피지컬 AI를 통해 LLM(거대 언어모델)에서 VLA(Vision-Language-Action)로의 진화하고 있다. 여기서 Vision은 로봇의 시각이다. 로봇은 카메라나 라이다(LiDAR)와 같은 센서를 통해 세상을 본다. 단순한 픽셀의 집합이 아니라, “이것은 깨지기 쉬운 컵이다”, “저것은 무거운 상자다”라는 의미론적 이해(Semantic Understanding)를 하기 시작했다.

두 번째 요소인 언어(Language)는 단순 명령어에서 나아가 로봇이 인간의 자연어를 이해하기 시작했다는 점이 다르다. “목이 마르다”라는 사용자의 말을 듣고 “냉장고에서 물을 가져와야 한다”라는 의도를 파악할 수 있게 되었다. 마지막으로 가장 중요한 단계인 행동(Action)이다. 추상적인 의도를 구체적인 모터의 제어 신호(Torque, Velocity, Position)로 변환한다. 젠슨 황 엔비디아 CEO는 지난해 CES에서 “로봇 공학의 챗GPT 순간(ChatGPT Moment)이 도래했다”라고 선언했다. 이는 텍스트를 생성하듯 로봇의 행동(Motion)을 생성해내는 시대가 열렸음을 의미한다.

오랫동안 로봇 공학을 괴롭혀온 것은 ‘모라벡의 역설’이었다. “인간에게 어려운 것(체스, 고도의 연산)은 컴퓨터에게 쉽고, 인간에게 쉬운 것(걷기, 수건 개기)은 컴퓨터에게 어렵다”라는 것이다. 그러나 이번 CES에서는 이 역설이 무너지고 있음을 보여주었다. 샤르파(Sharpa)의 로봇이 카드를 한 장씩 분리해 내는 섬세함이나, 다이나 로보틱스(Dyna Robotics)가 수건을 수천 장씩 접어내는 능력은, 이제 AI가 고도의 인지 능력뿐만 아니라 원초적인 감각 운동(Sensorimotor) 능력까지 정복하기 시작했음을 시사한다.

빅테크들의 로봇 신경계 구축 전쟁

로봇이라는 ‘육체’가 움직이기 위해서는 고도로 발달한 ‘신경계’가 필요하다. CES 2026은 로봇 하드웨어 제조사들의 무대이기도 했지만, 그 이면에서는 로봇의 뇌를 지배하려는 칩 제조 거인들의 전쟁터였다.

엔비디아는 단순한 칩 제조사를 넘어 로봇 생태계의 지휘자이자 로봇 훈련의 매트릭스를 제공하는 플랫폼 기업으로 진화했다. 지난해에 엔비디아 젠슨 황은 피지컬 AI를 위한 개발 플랫폼, 코스모스를 공개했다. 이번 CES 2026에서는 로봇이 물리적 세계를 이해하고 판단하는 능력을 강화시켰다. 코스모스를 통해 로봇은 텍스트 다음 단어를 예측하는 것이 아니라, 물리적 세계의 다음 상태를 예측할 수 있다. 로봇이 컵을 놓았을 때 그것이 떨어져 깨질지, 아니면 테이블 위에 안착할지를 시뮬레이션 속에서 미리 상상하고 행동하게 한다.

이번에 공개된 알파마요(Alpamayo)는 자율주행과 이동형 로봇을 위한 추론 기반 모델이다. 이는 로봇이 예기치 못한 장애물을 만났을 때 단순히 멈추는 것이 아니라, 우회하거나 장애물을 치우는 등 ‘판단’을 내릴 수 있게 한다. 로봇을 현실에서 직접 훈련시키는 것은 막대한 비용과 사고의 위험을 수반한다. 엔비디아는 이를 극복하기 위해 가상 공간에서 수십억 번의 시행착오를 선행 학습시키는 디지털 트윈 기술을 제안한다. 엔비디아는 디지털 트윈(Digital Twin) 기술을 통해 가상 공간에서 수십억 번의 시행착오를 겪게 한 뒤, 완성된 지능을 현실 로봇에 이식할 수 있는 로봇 시뮬레이션을 보여주고 있다.

엔비디아가 거대한 지능의 훈련에 집중한다면, 퀄컴은 현장에서의 실행과 효율성에 승부를 걸었다. 퀄컴은 로봇 전용 SoC(System-on-Chip) 드래곤윙을 공개했다. 로봇, 특히 휴머노이드는 배터리로 움직여야 하므로 전력 효율(Power Efficiency)이 생명이다. 전시장에서 퀄컴 관계자는 드래곤윙이 높은 연산 능력을 제공하면서도 낮은 전력 소모를 자랑하며 휴머노이드가 색깔별로 물건을 구분하는 시연을 보여주었다. 퀄컴은 오픈 AI와 제휴한 휴머노이드 스타트업 피규어와 협력하여 차세대 로봇의 두뇌를 설계하고 있다. 이는 스마트폰 시장을 지배했던 퀄컴의 스냅드래곤 생태계가 로봇 시장으로 전이되고 있음을 보여준다.

피지컬 AI, 가정으로 침투하다

대육화의 물결이 조심스럽게 닿은 곳은 바로 가정이다. LG전자는 ‘제로 레이버 홈’(Zero Labor Home)이라는 비전을 통해 가사 노동의 종식을 선언했다. LG전자가 공개한 클로이드는 상반신만 휴머노이드 형태를 가지면서 실용주의적인 노선을 택했다. 이족 보행 대신 바퀴형 베이스를 채택한 건 가정 내에서의 안정성을 최우선으로 고려한 결과다. 아이들이나 반려동물이 있는 환경에서 넘어질 위험이 있는 이족 보행 로봇은 아직 시기상조라는 판단이다. 대신 허리 관절과 양팔을 자유롭게 움직여 바닥의 물건을 줍거나 높은 선반의 물건을 꺼낼 수 있다. 특히, LG전자는 로봇 칩셋에 자체 개발한 VLM(Vision Language Model)과 VLA(Vision Language Action) 기술을 적용한 피지컬 AI 모델을 기반으로 가사 작업 데이터를 수만 시간 이상 학습시켜 홈로봇에 최적화시켰다.

CES 2026에서 가장 주목받은 시연은 빨래 접기였다. 클로이드는 건조기에서 나온 수건을 인식하고, 양팔을 이용해 이를 반듯하게 접었다. 비록 속도는 숙련된 인간에 비해 다소 느렸고, 빨래 바구니에서 엉킨 세탁물을 꺼내는 데는 어려움을 겪었지만, 정형화되지 않은 섬유를 다룬다는 점에서 기술적 진보를 증명했다. LG전자가 로봇 시연 중에 강조한 강점은 ‘연결성’이다. 로봇의 눈으로만 상황을 판단하는 것이 아니라, LG의 가전 생태계와 통신하며 세탁기가 “세탁이 끝났다”라는 신호를 보내면 클로이드가 움직이기 시작하는 등 다른 가전들과 통신할 수 있다.

미국의 스타트업 다이나 로보틱스(Dyna Robotics)도 주목을 받았다. 다이나 로보틱스는 화려한 로봇 춤이나 백덤블링 대신, 지루하지만 가치 있는 가사 작업에 집중했다. CES 전시장에서 다이나 로보틱스의 DYNA-1은 사람 개입 없이 로봇 손가락으로 옷이나 수건을 완벽하게 접어 옷 더미를 쌓아 제공하는 시연을 보여주었다. 현장 미팅을 해보니 호텔, 세탁소, 체육관, 식당 등에서도 실증하거나 일부 도입하고 있으며 세탁물 접기 이외 다른 작업도 학습이 가능하다고 했다. 다이나 로보틱스는 범용 로봇을 위한 파운데이션 모델(Foundation Model)을 통해 로봇에게 배우는 능력을 부여했다. VLA 모델을 기반으로 미묘한 피드백을 제공할 수 있는 정확한 보상 모델(RM)을 통해 정교한 로봇 작업을 할 수 있다.

어깨·고관절 360도 회전, 인간 한계를 넘다

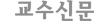

가정이 안전과 조심스러움의 무대라면, 산업 현장은 힘과 속도, 그리고 정밀함의 무대였다. 현대차그룹과 보스턴 다이내믹스(Boston Dynamics)는 이 무대의 주인공이었다. 현대차그룹은 CES 2026에서 완전 전동식 아틀라스를 일반 대중에게 처음으로 공개했다. 아틀라스가 다른 휴머노이드와 다른 점은 인간의 신체 구조를 모방하되, 인간의 한계에 얽매이지 않았다는 점이다. 어깨와 고관절이 360도 회전하여, 뒤에 있는 물건을 집기 위해 몸을 돌릴 필요 없이 상체만 회전시키거나 팔을 뒤로 꺾을 수 있다. 이는 좁은 조립 라인에서 동선을 최소화하고 작업 효율을 극대화할 수 있다.

또한, 새로운 아틀라스는 50kg(110파운드)의 무게를 들어 올릴 수 있으며, 영하 20도에서 영상 40도까지의 극한 환경에서도 작동한다. 또한 IP(Ingress Protection: 전자기기나 장비가 먼지와 물이 내부로 들어오는 것을 얼마나 막는지를 나타내는 국제 표준) 등급의 방수 기능을 갖춰 세척이 필요한 산업 현장에서도 견딜 수 있다는 강점이 있다.

‘휴머노이드 맥스(M.AX) 얼라이언스’ 공동관도 화제였다. 한국을 대표하는 휴머노이드 및 부품 기업들이 공동관을 꾸려 생산 공정 적용을 위한 피지컬 AI 로봇 시연을 보여주었다. 특히 에이로봇은 휴머노이드 두 대가 물류 공정에서 협업하는 모습을 시연했다. VLA를 기반으로 한 휴머노이드가 텀블러와 상자를 인식하여 상자 안에 텀블러들을 담아서 컨베이어 벨트로 보내면 다른 휴머노이드가 상자를 받아서 창고에 수납하는 시연을 반복해서 보여주었다.

대육화의 완성은 결국 섬세한 손끝

현대차의 아틀라스가 전신을 이용한 힘을 보여주었다면, 싱가포르 기반의 로봇 기업 샤르파(Sharpa)는 인간의 손을 초월하는 섬세함(Dexterity)을 보여주었다. 대육화의 완성은 결국 ‘손’에 달려 있다. CES 2026 현장에서 가장 많은 인파를 모은 데모 중 하나는 샤르파 부스였다.

로봇에게 얇은 트럼프 카드를 한 장씩 바닥에서 집어 올리거나, 카드 더미에서 분리해 내는 것은 매우 어려운 작업이다. 또한 종이접기도 쉽지 않은 작업이다. 종이는 얇고, 휘어지며, 정전기로 서로 달라붙기 때문이다. 이를 해결하기 위해서는 시각 정보만으로는 불가능하며, 손끝에서 느껴지는 미세한 마찰력과 압력의 변화를 감지해야 한다. 샤르파는 이를 위해 22개의 자유도(DoF)를 가진 로봇 손가락에 초소형 카메라, 촉각 센서를 내장하여 보면서 느끼는 기술을 구현했다. 1,000개 이상의 촉각 픽셀이 깃털처럼 가벼운 접촉부터 무거운 물체까지 0.005N의 정밀도로 감지한다.

샤르파는 단순 로봇손 제조만이 아닌 인간의 인지구조를 모방한 크래프트넷 아키텍처를 통해 인간의 척수 반사에 해당하는 시스템을 구현하여 물체가 로봇손에 닿는 0.01초 만에 악력을 조절할 수 있다. 샤르파는 피지컬 AI를 로봇 손의 정밀 제어 능력으로 구현하여 카드 더미에서 한 장을 정확하게 집어 블랙잭 게임을 주도하거나 30단계 이상의 바람개비를 접는 종이접기를 보여주었다. 샤르파의 인간과 로봇의 탁구 랠리는 로봇이 0.02초 반응을 자랑하며 참관하는 사람들로 북적거렸다.

피지컬 AI의 연주는 계속된다

CES 2026에서 목격한 ‘대육화’는 먼 미래의 공상과학이 아니었다. 그것은 이미 우리 곁에 와 있는 구체적인 현실이었다. ‘비바체’의 템포로 시작된 피지컬 AI의 콘서트는 이제 막 첫 악장을 마쳤을 뿐이다. 물론 한계는 여전하다. 배터리는 여전히 무겁고 빨리 닳으며, 피지컬 AI로 구현된 제조업용 로봇과 가정용 로봇은 여전히 느리고 서툴다. 그러나 피지컬 AI를 탑재한 로봇손의 혁신적인 아키텍처와 휴머노이드의 현장 작업 데이터와 같은 공유 자산이 축적되면서, 발전의 속도는 가속화될 것이다.

우리는 이제 ‘피지컬 AI’와 공존하는 삶을 준비해야 한다. 그것은 힘든 노동으로부터의 해방일 수도 있고, 인간 고유성에 대한 새로운 도전일 수도 있다. 분명한 것은 2026년의 라스베이거스에서 기계들이 걷거나 인간이 필요한 작업을 시작했으며, 그 행진은 멈추지 않을 것이라는 사실이다.

이경준

한국AI·로봇산업협회 기획사업본부장

gyeongjun@gmail.com

번역 제공

번역 제공